Mindestens vier Open-Source-Projekte zur Verarbeitung natürlicher Sprache, die riesige neuronale Netzwerke nutzen, konkurrieren derzeit mit dem einzigen großen kommerziellen NLP-Projekt: GPT-3 von OpenAI.

Die Open-Source-Initiativen zielen darauf ab, KI zu demokratisieren und ihre Entwicklung voranzutreiben. Alle diese Projekte basieren auf Transformer: ein spezieller Typ neuronaler Netzwerke, der sich für die Arbeit mit menschlichen Sprachstrukturen als besonders effizient erwiesen hat.

Was sind Transformatoren und warum sind die jüngsten Entwicklungen in diesem Bereich so wichtig?

Was sind Transformatoren in der Verarbeitung natürlicher Sprache?

Auf ihrem langen Weg zum Erfolg haben Forscher verschiedene neuronale Netzwerke für die Verarbeitung natürlicher Sprache ausprobiert. Schließlich kamen sie zu zwei Modellen, die entweder auf Convolutional Neural Networks (CNN) oder Recurrent Neural Networks (RNN) mit Aufmerksamkeit basieren.

Am Beispiel einer Übersetzungsaufgabe ist der Unterschied zwischen den beiden der folgende. Obwohl beide Typen berücksichtigen, was sie über einen gegebenen Satz gelernt haben, indem sie die vorherigen Wörter darin übersetzt haben, würden sie mit dem nächsten Wort in der Reihe mit unterschiedlichen Ansätzen fortfahren.

Ein CNN würde jedes Wort im Satz in parallelen Threads verarbeiten, während ein RNN mit Aufmerksamkeit sicherstellt, dass es jedes vorherige Wort im Satz im Hinblick auf seinen Einfluss auf die Bedeutung des nächsten Wortes gewichtet und so Wörter nacheinander verarbeitet. Ein CNN löst das Problem, die richtige Bedeutung für jedes Wort zu finden, nicht perfekt, kann aber schneller arbeiten; ein RNN erzeugt korrektere Ergebnisse, arbeitet aber langsam.

Kurz gesagt ist ein Transformer eine Kombination aus beidem. Er verwendet die Aufmerksamkeitstechnik, um den gegenseitigen Einfluss der einzelnen Wörter in einem Satz aufeinander zu bewerten. Andererseits arbeitet er dank mehrerer „Threads“ schneller: Paare sogenannter Encoder und Decoder, die beim Lernen helfen, das Gelernte anwenden und das erworbene Wissen an die nächste Iteration weitergeben.

Was können Transformatoren?

Abgesehen von der Übersetzung können Transformatoren vorhersagen, welches Wort als nächstes in einem Satz verwendet werden soll, und so ganze Sätze mit menschlich aussehender Sprache erzeugen.

Dadurch können wir sie für verschiedene Zwecke verwenden.

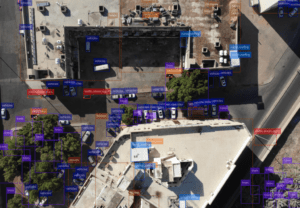

Die Fähigkeiten von Transformers zur Inhaltserstellung können zum Entwerfen besserer Chatbots, zum Schreiben von Webinhalten und zur Entlastung des technischen Supportpersonals genutzt werden. Der letzte Anwendungsfall ist mit der Fähigkeit von Transformers zur Informationssuche verbunden, die eine breite Palette von Anwendungen im realen Leben verspricht.

Abgesehen von rein menschlichen Sprachen können einige Transformer auch Programmiersprachen verarbeiten und sogar Skripte für andere Deep-Learning-Modelle erstellen. Programmierkenntnisse und die Fähigkeit, menschliche Sprache zu verstehen, machen Transformer zu Frontend-Entwicklern. Sie können auf die gleiche Weise wie ein menschlicher Entwickler eingewiesen werden und entwickeln ein Web-Layout.

Im Rahmen eines weiteren Experiments wurden Transformatoren in Excel integriert und konnten leere Zellen in einer Tabelle ausfüllen, indem sie Werte auf Grundlage der vorhandenen Daten in derselben Tabelle vorhersagten. Dadurch könnten wir umfangreiche Excel-Funktionen durch nur eine Transformatorformel ersetzen, die das Verhalten eines ganzen Algorithmus nachahmt.

Transformatoren könnten in Zukunft menschliche Entwicklungsbetriebsingenieure ersetzen, da sie in der Lage sein müssen, Systeme selbstständig zu konfigurieren und Infrastrukturen bereitzustellen.

Klingt nach Wow! Tatsächlich brachte das Jahr 2022 einige inspirierende Neuerungen in diesem Bereich.

Leistung und erforderliche Ressourcen von Transformatoren

Die Nachahmung der menschlichen Kunst der Sprachverarbeitung ist zu einem äußerst wettbewerbsintensiven Unterfangen geworden.

Die Erfolgsmessung ist keine Selbstverständlichkeit. Der Gewinner ist der Schnellste und Genaueste. Hohe Geschwindigkeit und Genauigkeit können Sie jedoch durch die Kombination zweier Hauptfaktoren erreichen:

- Ihre neuronale Netzwerkarchitektur; obwohl derzeit die Transformatorarchitektur dominiert;

- Die Anzahl der Parameter in Ihrem neuronalen Netzwerk.

Unter letzterem verstehen wir die Anzahl der Anschlüsse zwischen den Knoten in einem Netzwerk. Diese Zahl steht nicht unbedingt in linearer Beziehung zur Anzahl der Knoten, die der Größe des Netzwerks entsprechen würde.

Noch wichtiger ist jedoch, dass für Unternehmen, Forschungsgruppen und Einzelpersonen die Hauptfaktoren, die den Erfolg ihres Kindes beeinflussen, offenbar die Höhe der ihnen zur Verfügung stehenden Investitionen, die Größe der Trainingsdaten und der Zugang zu den menschlichen Talenten zur Entwicklung des Modells sind.

Die leistungsstärksten KI-Projekte der Welt

Unter Berücksichtigung der oben genannten Faktoren wollen wir uns ansehen, wer im KI-Wettbewerb führend ist.

GPT-3

OpenAIs GPT-3 (Generative Pre-Trained Transformer) war früher der Spitzenreiter im Rennen. Er enthält 175 Milliarden Parameter und kann selbstständig neue sprachbezogene Aufgaben erlernen. Er kann mehr als nur übersetzen: Eine seiner wichtigen Anwendungen ist das Beantworten von Fragen und das Klassifizieren von Informationen.

Es wurde mit 570 GB sauberer Daten aus 45 TB kuratierter Daten trainiert, was eine Menge ist. Sein Hauptnachteil ist, dass OpenAI weder freien Zugriff auf das Modell zur Verwendung noch auf seinen Code zur Verbesserung gewährt. Es bietet nur eine kommerzielle API zum Abrufen von Modellergebnissen. Folglich können nur die Forscher von OpenAI dazu beitragen.

Wie viele andere „spricht“ GPT-3 nur Englisch.

Wu Dao 2.0.

In quantitativer Hinsicht schlägt Wu Dao 2.0 GPT-3, da es mit 1,2 TB chinesischen Textdaten und 2,5 TB chinesischen Grafik Daten und 1,2 TB englische Textdaten. Es verfügt außerdem über 1,75 Billionen Parameter, 10-mal mehr als GPT-3.

Wu Dao 2.0 kann in verschiedenen Medienmodi arbeiten und sogar 3D-Strukturen entwerfen. Es wurde als Open Source angekündigt, ist aber aus irgendeinem Grund noch nicht auf GitHub erschienen.

Metaseq/OPT-175B

Meta, früher bekannt als Facebook, wurde oft mit dem Vorwurf konfrontiert, wichtige Forschungsergebnisse zu verbergen, zu denen die Menschheit hätte beitragen können. Ihr jüngster Versuch, Transformer-Modelle zugänglicher zu machen, könnte ihnen helfen, ihren ruinierten Ruf wiederherzustellen.

Wie sein Name schon sagt, verfügt der Transformer über 175 Milliarden Parameter. Er wurde als Kopie von GPT-3 erstellt, um dessen Leistung und Fähigkeiten zu entsprechen.

Ein weiterer Vorteil von Metaseq ist, dass sein GitHub-Repository hostet Modelle mit weniger Parametern, sodass Wissenschaftler sie nur für bestimmte Aufgaben optimieren und die hohen Wartungs- und Schulungskosten vermeiden können, die mit größeren Transformatormodellen verbunden sind.

Allerdings handelt es sich nicht vollständig um Open Source: Der Zugriff ist auf Forschungsgruppen beschränkt und muss von diesen beantragt und von Meta im Einzelfall genehmigt werden.

Öffnen Sie GPT-X

Es ist immer schade, wenn ein wissenschaftliches Projekt aus Angst vor dem Verpassen entsteht und nicht, weil gerade genug Inspiration dafür vorhanden ist. Das ist der Fall bei der GPT-X-Projekt: Es wird in Europa gepflegt und als Antwort auf GPT-3 und als Instrument zur Etablierung Europas „digitale Souveränität“. Das deutsche Frauenhofer-Institut ist der Haupttreiber seiner Entwicklung, unterstützt von seinen langjährigen Kooperationspartnern aus der deutschen und europäischen Industrie und Wissenschaft.

GPT-X ist erst vor Kurzem gestartet und es gibt nicht viele Informationen über seinen Fortschritt.

GPT-J und GPT-NEO

Eleuther KI ist eine unabhängige Forschungsgruppe, die das Ziel der Demokratisierung der KI verfolgt. Sie bieten zwei kleinere Modelle an: GPT-X mit 60 Milliarden Parametern und GPT-NEO mit nur 6 Milliarden. Interessanterweise übertrifft GPT-X GPT-3 bei Codierungsaufgaben und ist beim Geschichtenerzählen, Informationsabruf und Übersetzen genauso gut, was es zu einer perfekten Maschine für Chatbots macht.

Google Switch Transformer

Es war schwierig zu entscheiden, welche Namen auf dieser Liste landen sollten und welche nicht, aber Google verdient auf jeden Fall eine Erwähnung, und zwar aus zumindest zwei Gründen.

Der erste besteht darin, dass der Internetgigant seinen Transformator als Open Source zur Verfügung gestellt hat.

Der zweite Grund ist, dass die Schaltertransformator erhielt eine neuartige Architektur. Es verfügt über neuronale Netzwerke, die in den Schichten seines Haupt-Neuronalen Netzwerks verschachtelt sind. Dadurch kann die Leistung gesteigert werden, ohne die erforderliche Rechenleistung zu erhöhen.

Der Switch Transformer enthält 1,6 Milliarden Parameter. Trotzdem konnte er GPT-3 in puncto Genauigkeit und Flexibilität noch nicht übertreffen; höchstwahrscheinlich liegt dies an der geringeren Ausbildung des Switch Transformer.

Schlussfolgerung

Übrigens ist die Ausbildung in diesem Bereich ein dringendes Problem: Die Forscher haben bereits alle auf der Welt verfügbaren englischen Texte verwendet! Wahrscheinlich müssen sie Wu Daos Beispiel folgen und bald auf andere Sprachen umsteigen.

Ein weiteres Problem ist das, das der Switch Transformer bereits gelöst hat: mehr Netzwerkparameter bei weniger Berechnungen. Der Betrieb neuronaler Netzwerke verursacht große Mengen an Kohlendioxidemissionen. Daher muss eine bessere Leistung nicht nur aus kommerziellen, sondern auch aus ökologischen Gründen das Hauptziel bleiben.

Und genau das wird durch Open-Source-Projekte möglich: Sie versorgen dieses Forschungsfeld mit neuen (menschlichen) Köpfen, neuem Wissen und neuen Ideen.

KI und natürliche Sprachverarbeitung brauchen Inspiration aus der Praxis. Bei AI Superior verfolgen wir die Entwicklungen und freuen uns darauf, Erkenntnisse aus Open-Source-Projekten für unsere Industriekunden und ihre Bedürfnisse umzusetzen. Wir laden Sie ein, unsere Expertise in KI und natürlicher Sprachverarbeitung für jeden Anwendungsfall zu nutzen, von Online-Shops und Marktforschung bis hin zur Unterstützung der Ingenieurbranche.