تُنافس حاليًا أربعة مشاريع على الأقل مفتوحة المصدر لمعالجة اللغة الطبيعية، والتي تستغل شبكات عصبية ضخمة، مشروع معالجة اللغة الطبيعية التجاري الكبير الوحيد: GPT-3 التابع لشركة OpenAI. تهدف هذه المبادرات مفتوحة المصدر إلى إتاحة الذكاء الاصطناعي للجميع وتعزيز تطوره. وتعتمد جميع هذه المشاريع على المحولات: وهي نوع خاص من الشبكات العصبية أثبت أنه الأكثر فعالية في معالجة اللغة الطبيعية.

شركة الذكاء الاصطناعي للخدمات والتطوير

- خدمات وحلول الذكاء الاصطناعي لمساعدتك على تحقيق قيمة أكبر

- النتائج المفيدة لخدمات وحلول الذكاء الاصطناعي في الأعمال

- لماذا تختار الذكاء الاصطناعي المتفوق

- حلول الذكاء الاصطناعي التي يمكننا بناءها لمشروعك

- الصناعات

- عملية عملنا

- استكشف حالات عملائنا

- الجوائز والتقديرات لدينا

- الأسئلة الشائعة

- اطلع على AI Insights Hub من AI Superior

- دعونا نناقش مشروع الذكاء الاصطناعي القادم الخاص بك

خدمات وحلول الذكاء الاصطناعي لمساعدتك في فتح قيمة أكبر

AI Superior هي شركة خدمات ذكاء اصطناعي مقرها ألمانيا تركز على تطوير التطبيقات الشاملة المستندة إلى الذكاء الاصطناعي واستشارات الذكاء الاصطناعي. نقوم بتصميم وبناء تطبيقات الويب والهواتف المحمولة بالإضافة إلى منتجات برمجية مخصصة تعتمد على التعلم الآلي المعقد ونماذج وخوارزميات الذكاء الاصطناعي. إن علماء البيانات ومهندسي البرمجيات لدينا على مستوى الدكتوراه على استعداد لمساعدتك في إنشاء قصة نجاحك.

ابدأ بياناتك

رحلة

من المديرين التنفيذيين يعتقدون أن الذكاء الاصطناعي يساعد على تحسين عملية صنع القرار ويوفر ميزة تنافسية.

يمكن أتمتة الأنشطة في مختلف الصناعات بمساعدة الذكاء الاصطناعي.

من العملاء يتوقعون مشاركة شخصية من الشركات التي يمكن الوصول إليها بمساعدة الذكاء الاصطناعي.

تقليل الخسائر المالية بين المنظمات التي تستخدم الذكاء الاصطناعي للكشف عن الاحتيال.

شريك الخدمات

فريقنا من الاستشاريين ذوي المهارات العالية، والعديد منهم حاصلون على درجة الدكتوراه. حاصل على درجة علمية في الذكاء الاصطناعي أو المجالات ذات الصلة، ويمتلك معرفة واسعة وخبرة عملية في أنواع مختلفة من مشاريع الذكاء الاصطناعي. لقد قمنا بتطوير حلول تعتمد على الذكاء الاصطناعي لمختلف الصناعات، بدءًا من التأمين والبناء والتمويل وحتى الأدوية والعقارات.

بالإضافة إلى سنوات من الخبرة والمعرفة العميقة في مجال تطوير الذكاء الاصطناعي، نفخر باستخدام أحدث الأدوات والتقنيات. سواءً كنتم تتطلعون إلى اعتماد الذكاء الاصطناعي لأول مرة، أو ترغبون في تدقيق أنظمة الذكاء الاصطناعي الحالية، أو توسيع نطاقها، يُمكننا مساعدتكم!

تعد الشفافية والتواصل المستمر أمرًا بالغ الأهمية لنجاح أي مشروع أو حل للذكاء الاصطناعي. في AI Superior، نعطي الأولوية للتعاون الوثيق مع عملائنا، مما يضمن فهمهم لقيمة كل خطوة على طول الطريق. يتيح لنا نهجنا المرن التكيف مع أهداف مشروعك ومتطلباته، مما يوفر لك راحة البال.

باعتبارنا شركة خدمات ذكاء اصطناعي موثوقة، فإننا نقوم بدمج الذكاء الاصطناعي في عمليات مختلفة لتحقيق الكفاءة على المدى الطويل وضمان استمرارية الأعمال. من خلال التحليل الدقيق، نحدد المجالات والعمليات التي يمكن أن تضيف فيها الحلول المدعومة بالذكاء الاصطناعي قيمة كبيرة إلى عملك، مما يمكّنك من تسخير الإمكانات الكاملة للذكاء الاصطناعي.

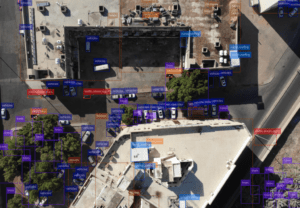

رؤية الكمبيوتر ومعالجة الصور

استفد من قوة رؤية الكمبيوتر لدفع تحليل الصور المؤثر ومعالجتها لتعزيز النمو وحل تحديات الأعمال. يمكن أن تساعدك تقنية الرؤية الحاسوبية لدينا، والتي تتضمن تحليل الفيديو واكتشاف الكائنات وتحليل الصور، في استخراج معلومات ذات معنى من مقاطع الفيديو والصور وتحويلها إلى رؤى قابلة للتنفيذ. سواء كنت تبحث عن تجزئة الصور، أو التحليل العاطفي، أو التعرف البصري على الأحرف، أو التعرف على الوجوه، أو تصنيف الصور السياقية، فإن AI Superior يلبي احتياجاتك.

معالجة اللغة الطبيعية

يؤدي كل تفاعل مع العميل، سواء كان ذلك من خلال وسائل التواصل الاجتماعي أو البريد الإلكتروني أو دردشة دعم العملاء، إلى توليد كمية كبيرة من البيانات النصية غير المنظمة في كل ثانية والتي يمكن أن تكون ذات قيمة للأعمال. من خلال خدمات معالجة اللغة الطبيعية لدينا، يمكنك اكتشاف رؤى لا تقدر بثمن من هذه البيانات، وحل مشكلات تحليل النص المتنوعة مثل تحليل المشاعر، والعثور على معلومات ذات معنى في ثوانٍ. يمكن لخبرائنا أيضًا المساعدة في تطوير تطبيقات البرمجة اللغوية العصبية (NLP) القوية مع ميزات مثل الإجابة على الأسئلة والتعرف على الكلام والبحث الدلالي والترجمة الآلية والتحكم في البريد العشوائي والمعنى العاطفي.

التحليلات التنبؤية

نظرًا لتغير مشهد الأعمال باستمرار، لم تعد البيانات التاريخية كافية لتحقيق عائد استثمار مربح. هذا هو المكان الذي يمكن أن تساعد فيه التحليلات التنبؤية. يتطلب الأمر البيانات الحالية والتاريخية لتوفير الاتجاهات والرؤى حول المستقبل من أجل اتخاذ قرارات أفضل تعتمد على البيانات. يمكن أن تساعدك خدمات التحليلات التنبؤية التي تقدمها AI Superior على توجيه الإجراءات بناءً على سلوك العميل واتجاهات السوق المتوقعة. بدءًا من اكتشاف الاحتيال والتنبؤ بفشل المعدات وحتى التنبؤ باتجاهات السوق، فإننا نضمن نماذج تنبؤية موثوقة ودقيقة يمكنها تعزيز الأعمال.

حلول ذكاء الأعمال

اتخذ قرارات أكثر ذكاءً بناءً على بيانات الأعمال باستخدام حلول ذكاء الأعمال الخاصة بنا. يمكننا مساعدتك في تحديد مجالات التحسين والمشكلات التنظيمية والفرص الجديدة لشركتك من خلال الاستفادة من البيانات الأولية غير المنظمة الواردة من مصادر متعددة. يمكن لحلول ذكاء الأعمال لدينا أن تساعد في تحسين الكفاءة التشغيلية وتقديم تصورات مقنعة للقرارات والاستراتيجيات المستندة إلى البيانات.

تحليلات البيانات الضخمة

اجعل عملية اتخاذ القرار أسرع وأفضل باستخدام تحليلات البيانات الضخمة في الوقت الفعلي. بفضل خبرتنا في تحليلات البيانات الضخمة، يمكننا المساعدة في تنفيذ القدرات التحليلية التي يمكنك استخدامها لحل تحديات الأعمال، والتنبؤ بالنتائج المستقبلية، واكتساب رؤى وأنماط جديدة قابلة للتنفيذ يمكن أن تجعل عملك أكثر كفاءة. يمكنك أيضًا تحليل البيانات من مصادر مختلفة، بما في ذلك السجلات وتطبيقات المعاملات وأجهزة الاستشعار، لتحديد فرص إنشاء خدمات ومنتجات جديدة وقياس المخاطر المحتملة واحتياجات العملاء.

بناء حلول الذكاء الاصطناعي الحائزة على جوائز عبر مجالات أعمال متعددة.

في AI Superior، نتبع منهجًا منظمًا لجميع مشاريع تطوير الذكاء الاصطناعي. عندما تختارنا كشريك لك، إليك ما يمكنك توقعه:

مرحلة الاكتشاف:

نبدأ بالفهم الشامل للمشكلة التي تهدف إلى حلها. ومن خلال التعاون الوثيق، نقوم بجمع الأفكار وتحديد الاتجاه العام والنهج للحل. نحن نقدم تقديرات عالية المستوى لنمنحك فهمًا واضحًا لنطاق المشروع والنتائج المتوقعة.

الإعداد الأولي:

بمجرد أن نفهم متطلباتك، فإننا نتعمق أكثر في فهم فريقك والبيانات اللازمة لمشروع ناجح. نقوم بتقييم مجموعة البيانات المتاحة لتحديد ما إذا كان الذكاء الاصطناعي هو الحل الأمثل لمعالجة المشكلة المطروحة.

بناء أفضل لاعب:

نحن نعتمد نهجًا تدريجيًا من خلال البدء صغيرًا واستخدام مجموعة البيانات المتاحة لاختبار جدوى فكرتنا. وهذا يسمح لنا بتحديد مدى فعالية الحل المقترح وتقييم مدى جدارته لمزيد من الاستثمار.

القياس والتكامل:

بعد النجاح في تطوير واختبار النموذج الأولي، نركز على دمج حل الذكاء الاصطناعي في نظامك الحالي. نحن نضمن التوافق السلس مع بياناتك، وضبط النماذج، وإجراء التعديلات اللازمة حسب الحاجة.

تقييم النتائج:

نحن نعمل معك بشكل وثيق لإجراء تقييم شامل لنتائج تكامل الذكاء الاصطناعي المطبق. هدفنا هو تقديم رؤى قيمة والتأكد من تفسيرها الدقيق، مما يتيح لك استخلاص أقصى قيمة من حل الذكاء الاصطناعي.

للشركات الناشئة

تقدم AI Superior خططًا ثابتة لتطوير الذكاء الاصطناعي مصممة خصيصًا لدعم الشركات الناشئة في كل مرحلة من مراحل عملية تطوير البرمجيات. بدءًا من إثبات مفهوم الذكاء الاصطناعي (PoC) وحتى المنتجات القابلة للتطوير بالكامل التي تستفيد من نماذج الذكاء الاصطناعي المتقدمة، تضمن خططنا نتيجة مضمونة بسعر محدد مسبقًا.

حلول الذكاء الاصطناعي المخصصة: نحن نبني حلول الذكاء الاصطناعي المصممة خصيصًا لتلبية احتياجات عملك وتحدياته. يعمل خبراء الذكاء الاصطناعي لدينا معك عن كثب لفهم متطلباتك الفريدة وتطوير أنظمة الذكاء الاصطناعي التي تلبي احتياجاتك، وتحسن الكفاءة، وتضعك في مقدمة المنافسين، وتحفز الابتكار.

استشارات الذكاء الاصطناعي: نحن متخصصون في تقديم التوجيه الاستراتيجي للشركات التي تتطلع إلى اعتماد الذكاء الاصطناعي لدفع النمو وتحسين العمليات. يقوم الخبراء في AI Superior بتقييم احتياجات عملك، وتحديد فرص الذكاء الاصطناعي، ووضع استراتيجية لتطوير الذكاء الاصطناعي وتنفيذه.

تطبيق: بمجرد وضع الخطة واعتبار حل الذكاء الاصطناعي قابلاً للتطبيق، تعمل شركة استشارات الذكاء الاصطناعي على تنفيذ المشروع. يتضمن ذلك بناء الإطار اللازم واختيار النموذج وتخصيصه ودمج حل الذكاء الاصطناعي مع النظام الحالي.

التدريب والتعليم في مجال الذكاء الاصطناعي: نحن نقدم وحدات تدريبية وورش عمل ومحاضرات للشركات التي تتطلع إلى رفع مهارات موظفيها في مجال الذكاء الاصطناعي. بدءًا من قواعد الترميز وحتى تدريب فريق علوم البيانات ومن ورش عمل التعلم الآلي واستخراج البيانات إلى المحاضرات حول تطوير برمجيات الذكاء الاصطناعي، فإننا نسعى جاهدين لتوفير مهارات الذكاء الاصطناعي الرائدة التي يمكن أن تحافظ على صلة أعمالك بمشهد الأعمال المتغير باستمرار اليوم.

تكامل ونشر الذكاء الاصطناعي: في AI Superior، نساعد الشركات على دمج الذكاء الاصطناعي في أنظمتها القديمة وسير العمل الحالي. يمكن لخبرائنا دمج الذكاء الاصطناعي في تطبيقات البرامج الحالية، وتحسين النماذج والخوارزميات لتحقيق أداء أسرع، ونشرها بسلاسة في عملياتك الحالية.

تحليل البيانات: يساعد المحترفون في AI Superior الشركات على استخراج المعلومات القيمة من البيانات الأولية باستخدام الذكاء الاصطناعي. يمكننا مساعدتك في تحديد الاتجاهات والأنماط وتقديم رؤى قابلة للتنفيذ لاتخاذ القرارات المستندة إلى البيانات.

يمكن أن يؤدي استخدام الذكاء الاصطناعي لتحليل سلوك العملاء وتفضيلاتهم وتقديم تجارب شخصية وتوصيات مخصصة إلى زيادة رضا العملاء، وارتفاع معدلات التحويل، وزيادة المشاركة والولاء، وهو أمر مفيد في نهاية المطاف للأعمال.

يمكن للذكاء الاصطناعي أيضًا أتمتة المهام العادية والمتكررة حتى يتمكن موظفوك من التركيز بشكل أكبر على الابتكار بدلاً من المهام الروتينية. ويمكنه أيضًا معالجة كميات هائلة من البيانات بسرعة وكفاءة ومعالجة الحسابات المعقدة، مما يؤدي إلى تحسين الإنتاجية وتقليل الأخطاء البشرية وتحسين الكفاءة. بالإضافة إلى ذلك، تساعد أتمتة المهام المتكررة الشركات على توفير الموارد والوقت.

إن الاستفادة الكاملة من الذكاء الاصطناعي يمكن أن تضعك في مقدمة منافسيك لأنه يسمح للشركات بتحديد الفرص الجديدة والاستجابة بسرعة لتغيرات السوق والابتكار بشكل أسرع.

توفر العديد من المنصات الذكاء الاصطناعي كخدمة وتسمح لك بتجربة خوارزميات وخدمات ML الخاصة بها. في AI Superior، ندرك أنه قد يكون من الصعب اختيار الأدوات والأنظمة الأساسية المناسبة التي تلبي احتياجاتك تمامًا في سوق اليوم الآخذ في التوسع، ولكن مستشاري الذكاء الاصطناعي لدينا يمكنهم مساعدتك. يمكن لخبرائنا إرشادك خلال عملية الاختيار ومساعدتك على دمج جميع الأدوات اللازمة في مشروعك.

Chatbots لخدمة عملاء أفضل: يمكن للشركات تبسيط وتحسين عمليات خدمة العملاء الخاصة بها باستخدام برامج الدردشة الآلية وتحرير ممثلي خدمة العملاء لديهم من المشكلات التي تتطلب التدخل البشري. يمكن لـ Chatbots أيضًا توجيه العملاء إلى الممثلين الذين يمكنهم الإجابة على أسئلتهم بشكل أفضل ويكونون متاحين على مدار الساعة طوال أيام الأسبوع لحل استفسارات العملاء.

توصيات شخصية: يستطيع الذكاء الاصطناعي تحليل سلوك العملاء والتوصية بالمنتجات التي تتوافق مع اهتمامات المستخدم. يحظى هذا بشعبية خاصة في مواقع التجارة الإلكترونية ومواقع البث المباشر. من خلال تحليل أنواع العروض والأفلام التي تشاهدها كثيرًا أو المنتجات التي تبحث عنها كثيرًا، يمكن للذكاء الاصطناعي أن يقدم لك عناوين مماثلة لإبقائك على المنصة لفترة أطول.

تقسيم الجمهور للحملات المستهدفة: يُستخدم الذكاء الاصطناعي في صناعة الإعلان لتقسيم المستخدمين إلى شرائح وإجراء حملات مستهدفة لتعزيز المبيعات، خاصة في الصناعات شديدة التنافسية.

تحليل المشاعر لرضا العملاء: يتيح تحليل المشاعر باستخدام الذكاء الاصطناعي للشركات قياس ردود أفعال العملاء وجمع الأفكار حول كيفية رؤية العملاء لعلامتهم التجارية من خلال مسح التقييمات والمراجعات والمشاركات التي تشير إلى العلامة التجارية. تساعد هذه الأفكار الشركات على تحديد المجالات التي يمكن تحسينها لضمان خدمة أفضل للعملاء.

الكشف عن الغش: تستخدم الشركات الذكاء الاصطناعي لتحديد الاحتيال والرد عليه ومنع الجرائم الإلكترونية. يتم استخدام خوارزميات مختلفة للتعلم الآلي لتحديد المعاملات المشبوهة، وعندما يكون هناك خطر الاحتيال، يتم إيقاف المعاملة وإبلاغ الأطراف ذات الصلة بالمخاطر.

تحسين سلسلة التوريد: يعد الذكاء الاصطناعي مفيدًا أيضًا للشركات التي تكافح من أجل تسليم المنتجات في الوقت المحدد. يمكن أن يساعد في التنبؤ بسعر المادة والشحن وتقدير الوقت الذي ستستغرقه المنتجات للمرور عبر سلسلة التوريد. ونتيجة لذلك، يمكن للشركات اتخاذ قرارات أفضل بشأن الطريقة المثلى لشحن المنتجات. كما يتم استخدامه بشكل شائع للعثور على طرق أسرع لمساعدة سائقي التوصيل.

دعونا نفكر في جميع إيجابيات وسلبيات أن تكون رائدًا في صناعة التعلم الآلي وأن تستخدم نهج SOTA في عملك. في AI Superior، نؤمن بشدة أنه من الضروري متابعة أحدث النتائج الأكاديمية في التعلم الآلي، لمعرفة أساليب التعلم الآلي المقترحة حديثًا، ومجموعات البيانات التدريبية، وكل ما له أهمية […]

غالبًا ما تثبت الطرق التقليدية لمراقبة المدن الحديثة عدم كفاءتها. فنظرًا لضخامة الجهد اليدوي اللازم، فإنها تتطلب موارد كثيرة قد تفتقر إليها المدينة. علاوة على ذلك، فإن ما يجب إنجازه يدويًا عرضة للأخطاء. لكن التطورات في الذكاء الاصطناعي وحلول الأجهزة ذات الصلة يمكن أن تُغير [...]

معالجة اللغة الطبيعية، المعروفة اختصارًا باسم NLP، تُمكّن برنامج الحاسوب من فهم اللغة البشرية كتابةً ونطقًا. ويُشار إليها باللغة الطبيعية، وهي جزء من الذكاء الاصطناعي. على مدار تاريخها الطويل الذي يزيد عن 50 عامًا، شملت معالجة اللغة الطبيعية مجموعةً واسعةً من التطبيقات العملية في مجالاتٍ متعددة، بما في ذلك [...]

سواءٌ أتيحت لك فرصة العمل بنظامٍ مُدعّمٍ بالذكاء الاصطناعي أم لا، فإنّ التقدمَ الحاليّ في هذا المجال يُذهل حتى مَن لا يملكون إلمامًا واسعًا به. إنّ الإمكانيات التي يُقدّمها الذكاء الاصطناعي في كلّ مجالٍ أو شريحةٍ مُحدّدةٍ هائلةٌ حقًّا، وهي في ازديادٍ مستمرّ مع مرور كلّ عام. إذا كنتَ [...]

بصفتك قائدًا في مجال الأعمال أو صانع قرار، قد يبدو تحديد الوقت المناسب وكيفية تبني التقنيات الناشئة مهمة شاقة. يُعدّ الذكاء الاصطناعي إحدى هذه التقنيات، ويحتل مكانة فريدة في سوق التقنيات الناشئة عمومًا. تشير التقديرات إلى أنه بحلول عام 2021، ستعتمد 801 تريليون روبية هندية من جميع التقنيات الناشئة على الذكاء الاصطناعي. باختصار، […]

- +49 6151 3943489

- [email protected]

- روبرت بوش-Str.7، 64293 دارمشتات، ألمانيا