Al menos cuatro proyectos de procesamiento del lenguaje natural de código abierto que explotan enormes redes neuronales compiten actualmente con el único gran proyecto comercial de PLN: GPT-3 de OpenAI. Estas iniciativas de código abierto buscan democratizar la IA e impulsar su evolución. Todos estos proyectos se basan en transformadores: un tipo especial de redes neuronales que han demostrado ser las más […]

Empresa de desarrollo y servicios de IA

- Servicios y soluciones de inteligencia artificial para ayudarle a generar mayor valor

- Resultados beneficiosos de los servicios y soluciones de inteligencia artificial en las empresas

- Por qué elegir AI Superior

- Soluciones de IA que podemos construir para su proyecto

- Industrias

- Nuestro proceso de trabajo

- Explore los casos de nuestros clientes

- Nuestros premios y reconocimientos

- Preguntas frecuentes

- Consulte AI Insights Hub de AI Superior

- Analicemos su próximo proyecto de IA

Servicios y soluciones de inteligencia artificial para ayudarle a desbloquear un mayor valor

AI Superior es una empresa de servicios de IA con sede en Alemania que se centra en el desarrollo de aplicaciones y consultoría de IA de extremo a extremo. Diseñamos y creamos aplicaciones web y móviles, así como productos de software personalizados que se basan en complejos modelos y algoritmos de aprendizaje automático e inteligencia artificial. Nuestros científicos de datos e ingenieros de software con nivel de doctorado están listos para ayudarlo a crear su historia de éxito.

Inicia tus datos

viaje

de los ejecutivos cree que la IA ayuda a mejorar la toma de decisiones y proporciona una ventaja competitiva.

de actividades en diversas industrias se pueden automatizar con la ayuda de la IA.

de los clientes esperan un compromiso personalizado de las empresas al que se puede llegar con la ayuda de la IA.

Reducción de pérdidas financieras entre organizaciones que utilizan IA para la detección de fraude.

socio de servicios

Nuestro equipo de consultores altamente calificados, muchos de los cuales tienen un doctorado. Licenciado en IA o campos relacionados, posee un amplio conocimiento y experiencia práctica con diferentes tipos de proyectos de IA. Hemos desarrollado soluciones basadas en IA para diversas industrias, desde seguros, construcción y finanzas hasta productos farmacéuticos y inmobiliarios.

Además de años de experiencia y un profundo conocimiento del sector en el desarrollo de IA, nos enorgullecemos de utilizar las herramientas y tecnologías más avanzadas. Ya sea que busque adoptar la IA por primera vez, auditar sistemas de IA existentes o escalar sus sistemas de IA, ¡podemos ayudarle!

La transparencia y la comunicación continua son fundamentales para el éxito de cualquier proyecto o solución de IA. En AI Superior, priorizamos la colaboración estrecha con nuestros clientes, asegurándonos de que comprendan el valor de cada paso del camino. Nuestro enfoque flexible nos permite adaptarnos a los objetivos y requisitos de su proyecto, brindándole tranquilidad.

Como empresa confiable de servicios de inteligencia artificial, integramos la IA en varios procesos para impulsar la eficiencia a largo plazo y garantizar la continuidad del negocio. A través de un análisis cuidadoso, identificamos áreas y operaciones donde las soluciones impulsadas por IA pueden agregar un valor sustancial a su negocio, permitiéndole aprovechar todo el potencial de la IA.

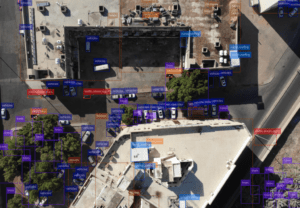

Visión por computadora y procesamiento de imágenes.

Aproveche el poder de la visión por computadora para impulsar un análisis y procesamiento de imágenes impactantes para mejorar el crecimiento y resolver los desafíos comerciales. Nuestra tecnología de visión por computadora, que incluye análisis de video, detección de objetos y análisis de imágenes, puede ayudarlo a extraer información significativa de videos e imágenes y convertirla en información útil. Ya sea que esté buscando segmentación de imágenes, análisis emocional, reconocimiento óptico de caracteres, reconocimiento facial o clasificación contextual de imágenes, AI Superior lo tiene cubierto.

Procesamiento natural del lenguaje

Cada interacción con el cliente, ya sea a través de las redes sociales, el correo electrónico o el chat de atención al cliente, genera un gran volumen de datos textuales no estructurados cada segundo que pueden ser valiosos para las empresas. Con nuestros servicios de procesamiento de lenguaje natural, puede descubrir información valiosa a partir de estos datos, resolver diversos problemas de análisis de texto, como el análisis de sentimientos, y encontrar información significativa en segundos. Nuestros expertos también pueden ayudar a desarrollar aplicaciones de PNL sólidas con funciones como respuesta a preguntas, reconocimiento de voz, búsqueda semántica, traducción automática, control de spam y significado emocional.

Análisis predictivo

Debido al panorama empresarial en constante cambio, los datos históricos ya no son suficientes para generar retornos de la inversión rentables. Aquí es donde el análisis predictivo puede ayudar. Se necesitan datos tanto actuales como históricos para proporcionar tendencias e información sobre el futuro para una mejor toma de decisiones basada en datos. Los servicios de análisis predictivo de AI Superior pueden ayudarle a impulsar acciones basadas en el comportamiento del cliente y las tendencias previstas del mercado. Desde la detección de fraudes y la predicción de fallos de equipos hasta la previsión de tendencias del mercado, garantizamos modelos predictivos fiables y precisos que pueden impulsar el negocio.

Soluciones de BI

Tome decisiones más inteligentes basadas en datos comerciales con nuestras soluciones de BI. Podemos ayudarlo a identificar áreas de mejora, problemas organizacionales y nuevas oportunidades para su negocio aprovechando datos sin procesar y no estructurados provenientes de múltiples orígenes. Nuestras soluciones de BI pueden ayudar a mejorar la eficiencia operativa y realizar una visualización convincente para decisiones y estrategias basadas en datos.

Análisis de grandes datos

Haga que la toma de decisiones sea más rápida y mejor con análisis de big data en tiempo real. Con nuestra experiencia en análisis de big data, podemos ayudarlo a implementar capacidades analíticas que puede utilizar para resolver desafíos comerciales, predecir resultados futuros y obtener nuevos conocimientos y patrones procesables que pueden hacer que su negocio sea más eficiente. También puede analizar datos de diferentes fuentes, incluidos registros, aplicaciones transaccionales y sensores, para identificar oportunidades para crear nuevos servicios y productos y evaluar riesgos potenciales y necesidades de los clientes.

Creación de soluciones de IA galardonadas en múltiples dominios empresariales.

En AI Superior, seguimos un enfoque sistemático para todos los proyectos de desarrollo de IA. Cuando nos elige como su socio, esto es lo que puede esperar:

Etapa de descubrimiento:

Comenzamos por comprender a fondo el problema que pretende resolver. A través de una estrecha colaboración, recopilamos conocimientos y definimos la dirección general y el enfoque de la solución. Proporcionamos estimaciones de alto nivel para brindarle una comprensión clara del alcance del proyecto y los resultados esperados.

Configuración inicial:

Una vez que comprendamos sus requisitos, profundizaremos en la comprensión de su equipo y los datos necesarios para un proyecto exitoso. Evaluamos el conjunto de datos disponible para determinar si la IA es la solución óptima para abordar el problema en cuestión.

MVP del edificio:

Adoptamos un enfoque incremental comenzando poco a poco y utilizando el conjunto de datos disponible para probar la viabilidad de nuestra idea. Esto nos permite determinar la efectividad de la solución propuesta y evaluar su valor para una mayor inversión.

Escalar e integrar:

Después de desarrollar y probar con éxito un prototipo, nos centramos en integrar la solución de IA en su sistema existente. Garantizamos una perfecta compatibilidad con sus datos, ajustamos los modelos y realizamos los ajustes necesarios según sea necesario.

Evaluación de resultados:

Trabajamos estrechamente con usted para evaluar exhaustivamente los resultados de la integración de IA implementada. Nuestro objetivo es proporcionar información valiosa y garantizar su interpretación precisa, permitiéndole obtener el máximo valor de la solución de IA.

para empresas emergentes

AI Superior ofrece planes fijos de desarrollo de IA diseñados para apoyar a las empresas emergentes en cada etapa del proceso de desarrollo de software. Desde pruebas de concepto (PoC) de IA hasta productos totalmente escalables que aprovechan modelos avanzados de IA, nuestros planes garantizan un resultado garantizado a un precio predefinido.

Soluciones de IA personalizadas: Creamos soluciones de IA adaptadas a las necesidades y desafíos de su negocio. Nuestros expertos en IA trabajan estrechamente con usted para comprender sus requisitos únicos y desarrollar sistemas de IA que satisfagan sus necesidades, mejoren la eficiencia, lo pongan por delante de sus competidores e impulsen la innovación.

Consultoría de IA: Nos especializamos en brindar orientación estratégica a empresas que buscan adoptar IA para impulsar el crecimiento y mejorar las operaciones. Los expertos de AI Superior evalúan sus necesidades comerciales, identifican oportunidades de IA y desarrollan una estrategia para el desarrollo y la implementación de la IA.

Implementación: Una vez que se implementa un plan y se considera viable una solución de IA, la empresa de consultoría de IA trabaja para implementar el proyecto. Esto implica construir el marco necesario, seleccionar y personalizar el modelo e integrar la solución de IA con el sistema existente.

Capacitación y educación en IA: Ofrecemos módulos de capacitación, talleres y conferencias para empresas que buscan mejorar las habilidades de sus empleados en IA. Desde reglas de codificación hasta capacitación de equipos de ciencia de datos y desde talleres de aprendizaje automático y minería de datos hasta conferencias sobre desarrollo de software de IA, nos esforzamos por brindar habilidades de IA líderes que puedan mantener su negocio relevante en el panorama empresarial en constante cambio actual.

Integración e implementación de IA: En AI Superior, ayudamos a las empresas a integrar la IA en sus sistemas y flujos de trabajo heredados existentes. Nuestros expertos pueden incorporar IA en aplicaciones de software existentes, optimizar modelos y algoritmos para un rendimiento más rápido e implementarlos sin problemas en sus procesos existentes.

Análisis de los datos: Los profesionales de AI Superior ayudan a las empresas a extraer información valiosa de datos sin procesar mediante IA. Podemos ayudarlo a identificar tendencias y patrones y brindarle información útil para la toma de decisiones basada en datos.

El uso de IA para analizar el comportamiento y las preferencias de los clientes y brindar experiencias personalizadas y recomendaciones personalizadas puede generar una mayor satisfacción del cliente, mayores tasas de conversión y un mayor compromiso y lealtad, lo que en última instancia es bueno para los negocios.

La IA también puede automatizar tareas mundanas y repetitivas para que sus empleados puedan concentrarse más en innovar que en tareas rutinarias. También puede procesar enormes cantidades de datos de forma rápida y eficiente y procesar cálculos complejos, lo que conduce a una mayor productividad, una reducción del error humano y una mayor eficiencia. Además, la automatización de tareas repetitivas ayuda a las empresas a ahorrar recursos y tiempo.

Aprovechar al máximo la IA también puede situarlo por delante de su competencia, ya que permite a las empresas identificar nuevas oportunidades, responder rápidamente a los cambios del mercado e innovar más rápidamente.

Numerosas plataformas ofrecen IA como servicio y le permiten experimentar con sus algoritmos y servicios de aprendizaje automático. En AI Superior, entendemos que puede resultar abrumador elegir las herramientas y plataformas adecuadas que satisfagan completamente sus necesidades en el mercado actual en constante expansión, pero nuestros consultores de IA pueden ayudarlo. Nuestros expertos pueden guiarle a través del proceso de selección y ayudarle a integrar todas las herramientas necesarias en su proyecto.

Chatbots para un mejor servicio al cliente: Las empresas pueden agilizar y mejorar sus procesos de atención al cliente con chatbots y liberar a sus representantes de atención al cliente para problemas que requieran intervención humana. Los chatbots también pueden dirigir a los clientes a representantes que pueden responder mejor a sus preguntas y estar disponibles las 24 horas del día, los 7 días de la semana para resolver las consultas de los clientes.

Recomendaciones personalizadas: La IA puede analizar el comportamiento del cliente y recomendar productos que se alineen con los intereses del usuario. Esto es particularmente popular en los sitios web de comercio electrónico y transmisión. Al analizar los tipos de programas y películas que ves con más frecuencia o los productos que más buscas, la IA puede presentarte títulos similares para mantenerte en la plataforma por más tiempo.

Segmentación de audiencia para campañas específicas: La IA se utiliza en la industria publicitaria para segmentar a los usuarios y realizar campañas específicas para impulsar las ventas, especialmente en industrias altamente competitivas.

Análisis de sentimiento para la satisfacción del cliente: El análisis de sentimientos con IA permite a las empresas medir las reacciones de los clientes y recopilar información sobre cómo ven los clientes su marca mediante la exploración de calificaciones, reseñas y publicaciones que mencionan la marca. Estos conocimientos ayudan a las empresas a identificar áreas que se pueden mejorar para garantizar un mejor servicio al cliente.

Detección de fraude: Las empresas utilizan la IA para identificar y responder al fraude y prevenir el ciberdelito. Se utilizan diferentes algoritmos de aprendizaje automático para identificar transacciones sospechosas y, siempre que existe riesgo de fraude, la transacción se detiene y se informa del riesgo a las partes pertinentes.

Optimización de la cadena de suministro: La IA también es útil para las empresas que luchan por entregar los productos a tiempo. Puede ayudar a predecir el precio del material y el envío y estimar el tiempo que tardarán los productos en pasar por la cadena de suministro. Como resultado, las empresas pueden tomar mejores decisiones sobre la forma óptima de enviar productos. También se usa comúnmente para encontrar rutas más rápidas para ayudar a los repartidores.

Consideremos todos los pros y contras de ser pionero en la industria del aprendizaje automático e incorporar enfoques SOTA a su negocio. En AI Superior, creemos firmemente que es esencial seguir los hallazgos académicos más recientes en ML, conocer los métodos de aprendizaje automático recientemente propuestos, los conjuntos de datos de entrenamiento y todo lo que tenga importancia […]

Los métodos tradicionales de monitorización de las ciudades modernas suelen resultar ineficientes. Debido al gran esfuerzo manual necesario, requieren una gran cantidad de recursos de los que una ciudad puede carecer. Además, lo que debe hacerse manualmente es propenso a errores. Pero los avances en IA y las soluciones de hardware relacionadas pueden cambiar […]

El procesamiento del lenguaje natural, comúnmente conocido como PLN, permite que un programa informático comprenda el lenguaje humano tal como se escribe y se habla. Se le conoce como lenguaje natural y forma parte de la inteligencia artificial. Con más de 50 años de existencia, el PLN ha incluido diversas aplicaciones prácticas en diversos campos, incluyendo […]

Independientemente de si ha tenido la oportunidad de trabajar con un sistema impulsado por IA o no, los avances actuales en este campo sorprenden incluso a quienes tienen poco conocimiento al respecto. Las posibilidades que ofrece la IA en cualquier área o nicho son realmente magníficas y siguen creciendo año tras año. Si tiene […]

Como líder empresarial o responsable de la toma de decisiones, saber cuándo y cómo adoptar tecnologías emergentes puede parecer una tarea abrumadora. La Inteligencia Artificial (IA) es una de ellas y ocupa un lugar único en el mercado de las tecnologías emergentes en general. Se estima que para 2021, el 80% de todas las tecnologías emergentes se basarán en IA. En resumen, […]

- +49 6151 3943489

- [email protected]

- Robert-Bosch-Str.7, 64293 Darmstadt, Alemania