Ten minste vier open-sourceprojecten voor natuurlijke taalverwerking, die gebruikmaken van enorme neurale netwerken, vormen momenteel een uitdaging voor het enige grote commerciële NLP-project: GPT-3 van OpenAI. De open-source-initiatieven hebben als doel AI te democratiseren en de evolutie ervan te versnellen. Al deze projecten zijn gebaseerd op transformers: een speciaal type neurale netwerken die bewezen hebben de meest […].

AI-diensten- en ontwikkelingsbedrijf

- Kunstmatige intelligentiediensten en -oplossingen waarmee u meer waarde kunt ontsluiten

- Gunstige resultaten van kunstmatige-intelligentiediensten en -oplossingen in het bedrijfsleven

- Waarom kiezen voor AI Superior

- AI-oplossingen die we voor uw project kunnen bouwen

- Industrieën

- Ons werkproces

- Ontdek onze klantcases

- Onze prijzen en erkenningen

- Veelgestelde vragen

- Bekijk AI Insights Hub van AI Superior

- Laten we uw volgende AI-project bespreken

Diensten en oplossingen voor kunstmatige intelligentie om u te helpen meer waarde te ontsluiten

AI Superior is een in Duitsland gevestigd AI-dienstenbedrijf dat zich richt op de end-to-end AI-gebaseerde applicatieontwikkeling en AI-advies. We ontwerpen en bouwen web- en mobiele apps, evenals softwareproducten op maat die afhankelijk zijn van complexe machine learning- en AI-modellen en -algoritmen. Onze datawetenschappers en software-ingenieurs op PhD-niveau staan klaar om u te helpen uw succesverhaal te creëren.

Begin met uw gegevens

reis

van de leidinggevenden is van mening dat AI de besluitvorming helpt verbeteren en een concurrentievoordeel oplevert.

van activiteiten in verschillende industrieën kan worden geautomatiseerd met behulp van AI.

van de klanten verwacht gepersonaliseerde betrokkenheid van bedrijven die kan worden bereikt met behulp van AI.

vermindering van financiële verliezen bij organisaties die AI gebruiken voor fraudedetectie.

dienstenpartner

Ons team van zeer bekwame consultants, van wie velen een Ph.D. diploma in AI of aanverwante gebieden, beschikt over uitgebreide kennis en praktische ervaring met verschillende soorten AI-projecten. We hebben AI-gestuurde oplossingen ontwikkeld voor verschillende sectoren, variërend van verzekeringen, bouw en financiën tot farmaceutica en onroerend goed.

Naast jarenlange ervaring en diepgaande domeinkennis in AI-ontwikkeling, zijn we er trots op dat we de nieuwste tools en technologieën gebruiken. Of u nu voor het eerst AI wilt implementeren, bestaande AI-systemen wilt auditen of uw AI-systemen wilt opschalen, wij kunnen u helpen!

Transparantie en continue communicatie zijn van cruciaal belang voor het succes van elk AI-project of -oplossing. Bij AI Superior geven we prioriteit aan nauwe samenwerking met onze klanten, zodat ze de waarde van elke stap onderweg begrijpen. Dankzij onze flexibele aanpak kunnen we ons aanpassen aan de doelstellingen en vereisten van uw project, waardoor u gemoedsrust krijgt.

Als een vertrouwd dienstverlenend bedrijf op het gebied van kunstmatige intelligentie integreren we AI in verschillende processen om de efficiëntie op de lange termijn te bevorderen en de bedrijfscontinuïteit te garanderen. Door middel van een zorgvuldige analyse identificeren we gebieden en activiteiten waar AI-aangedreven oplossingen substantiële waarde kunnen toevoegen aan uw bedrijf, waardoor u het volledige potentieel van AI kunt benutten.

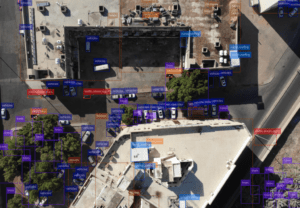

Computervisie en beeldverwerking

Benut de kracht van computer vision om impactvolle beeldanalyse en -verwerking te stimuleren om de groei te verbeteren en zakelijke uitdagingen op te lossen. Onze computer vision-technologie, die videoanalyse, objectdetectie en beeldanalyse omvat, kan u helpen betekenisvolle informatie uit video's en afbeeldingen te halen en deze om te zetten in bruikbare inzichten. Of u nu op zoek bent naar beeldsegmentatie, emotionele analyse, optische karakterherkenning, gezichtsherkenning of contextuele beeldclassificatie, AI Superior heeft het voor u.

Natuurlijke taalverwerking

Elke klantinteractie, of dat nu via sociale media, e-mail of klantenservicechat is, genereert elke seconde een grote hoeveelheid ongestructureerde tekstuele gegevens die waardevol kunnen zijn voor het bedrijfsleven. Met onze diensten voor natuurlijke taalverwerking kunt u waardevolle inzichten uit deze gegevens ontdekken, verschillende problemen met tekstanalyse oplossen, zoals sentimentanalyse, en binnen enkele seconden betekenisvolle informatie vinden. Onze experts kunnen ook helpen bij het ontwikkelen van robuuste NLP-apps met functies zoals het beantwoorden van vragen, spraakherkenning, semantisch zoeken, automatische vertaling, spamcontrole en emotionele betekenis.

Voorspellende analyse

Vanwege het voortdurend veranderende zakelijke landschap zijn historische gegevens niet langer voldoende om winstgevende ROI's te genereren. Dit is waar voorspellende analyses kunnen helpen. Er zijn zowel huidige als historische gegevens nodig om trends en inzichten over de toekomst te bieden voor betere datagestuurde besluitvorming. De voorspellende analysediensten van AI Superior kunnen u helpen acties te stimuleren op basis van klantgedrag en voorspelde markttrends. Van fraudedetectie en het voorspellen van defecten aan apparatuur tot het voorspellen van markttrends: wij garanderen betrouwbare en nauwkeurige voorspellende modellen die de bedrijfsvoering kunnen stimuleren.

BI-oplossingen

Neem slimmere beslissingen op basis van bedrijfsgegevens met onze BI-oplossingen. Wij kunnen u helpen bij het identificeren van verbeterpunten, organisatorische problemen en nieuwe kansen voor uw bedrijf door gebruik te maken van ruwe, ongestructureerde gegevens afkomstig van meerdere bronnen. Onze BI-oplossingen kunnen de operationele efficiëntie helpen verbeteren en overtuigende visualisaties maken voor datagestuurde beslissingen en strategieën.

Big Data-analyse

Maak besluitvorming sneller en beter met big data-analyse in realtime. Met onze expertise op het gebied van big data-analyse kunnen we u helpen analytische mogelijkheden te implementeren die u kunt gebruiken om zakelijke uitdagingen op te lossen, toekomstige resultaten te voorspellen en nieuwe bruikbare inzichten en patronen te verkrijgen die uw bedrijf efficiënter kunnen maken. U kunt ook gegevens uit verschillende bronnen analyseren, waaronder logboeken, transactionele toepassingen en sensoren, om kansen te identificeren voor het creëren van nieuwe diensten en producten en het in kaart brengen van potentiële risico's en klantbehoeften.

Het bouwen van bekroonde AI-oplossingen voor meerdere bedrijfsdomeinen.

Bij AI Superior volgen we een systematische aanpak voor alle AI-ontwikkelingsprojecten. Wanneer u ons als uw partner kiest, kunt u het volgende verwachten:

Ontdekkingsfase:

We beginnen met het grondig begrijpen van het probleem dat u wilt oplossen. Door nauwe samenwerking verzamelen we inzichten en bepalen we de algemene richting en aanpak voor de oplossing. Wij bieden schattingen op hoog niveau om u een duidelijk inzicht te geven in de reikwijdte van het project en de verwachte resultaten.

Initiële setup:

Zodra we uw vereisten begrijpen, gaan we dieper in op het begrijpen van uw team en de gegevens die nodig zijn voor een succesvol project. We beoordelen de beschikbare dataset om te bepalen of AI de optimale oplossing is om het probleem aan te pakken.

MVP opbouwen:

We hanteren een stapsgewijze aanpak door klein te beginnen en de beschikbare dataset te gebruiken om de levensvatbaarheid van ons idee te testen. Hierdoor kunnen we de effectiviteit van de voorgestelde oplossing bepalen en beoordelen of deze geschikt is voor verdere investeringen.

Schalen en integreren:

Na het succesvol ontwikkelen en testen van een prototype, richten wij ons op het integreren van de AI-oplossing in uw bestaande systeem. Wij zorgen voor een naadloze compatibiliteit met uw gegevens, stemmen de modellen af en voeren indien nodig de nodige aanpassingen uit.

Resultaten evalueren:

We werken nauw met u samen om de resultaten van de geïmplementeerde AI-integratie uitgebreid te evalueren. Ons doel is om waardevolle inzichten te bieden en de juiste interpretatie ervan te garanderen, zodat u maximale waarde uit de AI-oplossing kunt halen.

voor startups

AI Superior biedt vaste AI-ontwikkelingsplannen die zijn afgestemd op het ondersteunen van startups in elke fase van het softwareontwikkelingsproces. Van AI proof of concept (PoC) tot volledig schaalbare producten die gebruikmaken van geavanceerde AI-modellen: onze plannen garanderen een gegarandeerd resultaat tegen een vooraf gedefinieerde prijs.

Aangepaste AI-oplossingen: Wij bouwen AI-oplossingen op maat van uw zakelijke behoeften en uitdagingen. Onze AI-experts werken nauw met u samen om uw unieke vereisten te begrijpen en AI-systemen te ontwikkelen die aan uw behoeften voldoen, de efficiëntie verbeteren, u een voorsprong geven op de concurrentie en innovatie stimuleren.

AI-advies: Wij zijn gespecialiseerd in het bieden van strategische begeleiding aan bedrijven die AI willen inzetten om groei te stimuleren en hun activiteiten te verbeteren. Deskundigen van AI Superior beoordelen uw bedrijfsbehoeften, identificeren AI-kansen en ontwikkelen een strategie voor de ontwikkeling en implementatie van AI.

Implementatie: Zodra er een plan is opgesteld en een AI-oplossing levensvatbaar wordt geacht, gaat het AI-adviesbureau aan de slag om het project te implementeren. Dit omvat het bouwen van het noodzakelijke raamwerk, het selecteren en aanpassen van het model en het integreren van de AI-oplossing met het bestaande systeem.

AI-training en onderwijs: We bieden trainingsmodules, workshops en lezingen voor bedrijven die hun werknemers willen bijscholen in AI. Van codeerregels tot data science-teamtraining en van workshops over machinaal leren en datamining tot lezingen over de ontwikkeling van AI-software: we streven ernaar toonaangevende AI-vaardigheden te bieden die uw bedrijf relevant kunnen houden in het voortdurend veranderende zakelijke landschap van vandaag.

AI-integratie en -implementatie: Bij AI Superior helpen we bedrijven AI te integreren in hun bestaande bestaande systemen en workflows. Onze experts kunnen AI in bestaande softwareapplicaties integreren, modellen en algoritmen optimaliseren voor snellere prestaties en deze naadloos in uw bestaande processen implementeren.

Gegevensanalyse: Professionals van AI Superior helpen bedrijven waardevolle informatie uit ruwe gegevens te halen met behulp van AI. Wij kunnen u helpen trends en patronen te identificeren en bruikbare inzichten te bieden voor datagestuurde besluitvorming.

Het gebruik van AI om het gedrag en de voorkeuren van klanten te analyseren en gepersonaliseerde ervaringen en aanbevelingen op maat te bieden, kan resulteren in een hogere klanttevredenheid, hogere conversiepercentages en een grotere betrokkenheid en loyaliteit, wat uiteindelijk goed is voor het bedrijfsleven.

AI kan ook alledaagse en repetitieve taken automatiseren, zodat uw medewerkers zich meer kunnen concentreren op innovatie in plaats van op routinetaken. Het kan ook grote hoeveelheden gegevens snel en efficiënt verwerken en complexe berekeningen verwerken, wat leidt tot een hogere productiviteit, minder menselijke fouten en een betere efficiëntie. Bovendien helpt het automatiseren van repetitieve taken bedrijven middelen en tijd te besparen.

Het volledig benutten van AI kan u ook een voorsprong geven op uw concurrent, omdat bedrijven hiermee nieuwe kansen kunnen identificeren, snel kunnen reageren op marktveranderingen en sneller kunnen innoveren.

Talrijke platforms bieden AI als een service en stellen u in staat te experimenteren met hun ML-algoritmen en -services. Bij AI Superior begrijpen we dat het overweldigend kan zijn om de juiste tools en platforms te kiezen die volledig aan uw behoeften voldoen in de steeds groter wordende markt van vandaag, maar onze AI-consultants kunnen u helpen. Onze experts kunnen u door het selectieproces begeleiden en u helpen alle benodigde tools in uw project te integreren.

Chatbots voor een betere klantenservice: Bedrijven kunnen hun klantenserviceprocessen stroomlijnen en verbeteren met chatbots en hun klantenservicemedewerkers de tijd geven voor problemen die menselijke tussenkomst vereisen. Chatbots kunnen klanten ook doorverwijzen naar vertegenwoordigers die hun vragen beter kunnen beantwoorden en 24/7 beschikbaar zijn om klantvragen op te lossen.

Gepersonaliseerde aanbevelingen: AI kan klantgedrag analyseren en producten aanbevelen die aansluiten bij de interesses van de gebruiker. Dit is vooral populair bij e-commerce- en streamingwebsites. Door de soorten programma's en films te analyseren die u het meest bekijkt of de producten waarnaar u het meest zoekt, kan de AI u soortgelijke titels presenteren, zodat u langer op het platform kunt blijven.

Doelgroepsegmentatie voor gerichte campagnes: AI wordt in de advertentie-industrie gebruikt om gebruikers te segmenteren en gerichte campagnes te maken om de verkoop te stimuleren, vooral in zeer concurrerende industrieën.

Sentimentanalyse voor klanttevredenheid: Sentimentanalyse met AI stelt bedrijven in staat de reacties van klanten te meten en inzichten te verzamelen over hoe klanten hun merk zien door beoordelingen, recensies en berichten te scannen waarin het merk wordt vermeld. Deze inzichten helpen bedrijven bij het identificeren van gebieden die kunnen worden verbeterd om een betere klantenservice te garanderen.

Fraude detectie: Bedrijven gebruiken AI om fraude te identificeren en erop te reageren en cybercriminaliteit te voorkomen. Er worden verschillende machine learning-algoritmen gebruikt om verdachte transacties te identificeren. Wanneer er risico op fraude bestaat, wordt de transactie stopgezet en worden relevante partijen op de hoogte gebracht van het risico.

Optimaliseren van de toeleveringsketen: AI is ook nuttig voor bedrijven die moeite hebben om producten op tijd te leveren. Het kan helpen bij het voorspellen van de prijs van het materiaal en de verzending, en bij het inschatten van de tijd die de producten nodig hebben om door de toeleveringsketen te gaan. Hierdoor kunnen bedrijven betere beslissingen nemen over de optimale manier van verzenden van producten. Het wordt ook vaak gebruikt om snellere routes te vinden om bezorgers te helpen.

Laten we alle voor- en nadelen van pionieren in de machine learning-industrie en het introduceren van SOTA-benaderingen in uw bedrijf eens bekijken. Bij AI Superior geloven we er sterk in dat het essentieel is om de meest recente academische bevindingen in ML te volgen, om recent voorgestelde machine learning-methoden, trainingsdatasets en alles wat van belang is te kennen […]

Traditionele manieren om moderne steden te monitoren blijken vaak inefficiënt. Door de enorme hoeveelheid handmatige inspanning die nodig is, vereisen ze veel middelen die een stad mogelijk niet heeft. Bovendien is wat handmatig moet worden gedaan, foutgevoelig. Maar vooruitgang in AI en gerelateerde hardwareoplossingen kan de […]

Natuurlijke taalverwerking, algemeen bekend als NLP, stelt het computerprogramma in staat om de menselijke taal te begrijpen zoals die geschreven en gesproken wordt. Het wordt ook wel natuurlijke taal genoemd, een onderdeel van kunstmatige intelligentie. Met zijn lange bestaan van meer dan 50 jaar heeft NLP een scala aan praktische toepassingen in diverse vakgebieden omvat, waaronder […]

Of je nu wel of niet de kans hebt gehad om met een AI-gestuurd systeem te werken, de huidige vooruitgang op dit gebied verbaast zelfs mensen die er weinig vanaf weten. De mogelijkheden die AI biedt op elk gebied of in elke niche zijn werkelijk fantastisch en blijven elk jaar groeien. Als je […]

Als bedrijfsleider of besluitnemer kan het een lastige opgave lijken om te weten wanneer en hoe je opkomende technologieën moet implementeren. Kunstmatige intelligentie (AI) is zo'n technologie en neemt een unieke positie in binnen de markt voor opkomende technologieën in het algemeen. Naar schatting zal in 2021 801 TP3T van alle opkomende technologieën gebaseerd zijn op AI. Simpel gezegd, […]

- +49 6151 3943489

- [email protected]

- Robert-Bosch-Str.7, 64293 Darmstadt, Duitsland