Mindestens vier Open-Source-Projekte zur Verarbeitung natürlicher Sprache (NLP), die riesige neuronale Netze nutzen, fordern derzeit das einzige große kommerzielle NLP-Projekt heraus: GPT-3 von OpenAI. Die Open-Source-Initiativen zielen darauf ab, KI zu demokratisieren und ihre Weiterentwicklung zu beschleunigen. Alle diese Projekte basieren auf Transformer-Netzwerken: einer speziellen Art von neuronalen Netzen, die sich als besonders leistungsfähig erwiesen haben.

KI Dienstleistungen und Entwicklungsunternehmen

- Dienstleistungen und Lösungen für künstliche Intelligenz, die Ihnen helfen, mehr Wert zu schaffen

- Vorteilhafte Ergebnisse von Dienstleistungen und Lösungen der künstlichen Intelligenz in der Wirtschaft

- Warum AI Superior wählen?

- AI-Lösungen, die wir für Ihr Projekt entwickeln können

- Branchen

- Unser Arbeitsprozess

- Entdecken Sie unsere Kundenfälle

- Unsere Auszeichnungen und Anerkennungen

- FAQs

- Besuchen Sie AI Insights Hub von AI Superior

- Lassen Sie uns über Ihr nächstes AI-Projekt sprechen

Dienstleistungen und Lösungen für künstliche Intelligenz , die Ihnen helfen, mehr Wert zu schaffen

AI Superior ist ein in Deutschland ansässiges KI-Dienstleistungsunternehmen, das sich auf End-to-End-KI-basierte Anwendungsentwicklung und KI-Beratung konzentriert. Wir entwerfen und erstellen Web- und Mobilanwendungen sowie kundenspezifische Softwareprodukte, die auf komplexen maschinellen Lern- und KI-Modellen und -Algorithmen basieren. Unsere promovierten Data Scientists und Software-Ingenieure sind bereit, Sie bei der Entwicklung Ihrer Erfolgsgeschichte zu unterstützen.

Beginnen Sie Ihre Reise

mit Daten

der Führungskräfte glauben, dass KI zur Verbesserung der Entscheidungsfindung beiträgt und einen Wettbewerbsvorteil darstellt.

von Tätigkeiten in verschiedenen Branchen können mit Hilfe von KI automatisiert werden.

der Kunden erwarten ein personalisiertes Engagement von Unternehmen, das mit Hilfe von KI erreicht werden kann.

Reduzierung der finanziellen Verluste bei Unternehmen, die KI zur Betrugserkennung einsetzen.

wählen sollten

Unser Team aus hochqualifizierten Beratern, von denen viele einen Doktortitel in KI oder verwandten Bereichen haben, verfügt über umfassende Kenntnisse und praktische Erfahrungen mit verschiedenen Arten von KI-Projekten. Wir haben KI-gestützte Lösungen für verschiedene Branchen entwickelt, von der Versicherungs-, Bau- und Finanzbranche bis hin zur Pharma- und Immobilienbranche.

Neben langjähriger Erfahrung und fundiertem Fachwissen in der KI-Entwicklung setzen wir auf die neuesten Tools und Technologien. Egal, ob Sie KI zum ersten Mal einsetzen, bestehende KI-Systeme prüfen oder Ihre KI-Systeme skalieren möchten – wir helfen Ihnen!

Transparenz und kontinuierliche Kommunikation sind für den Erfolg eines jeden KI-Projekts oder einer KI-Lösung von entscheidender Bedeutung. Bei AI Superior legen wir großen Wert auf eine enge Zusammenarbeit mit unseren Kunden, um sicherzustellen, dass sie den Wert jedes einzelnen Schritts auf dem Weg dorthin verstehen. Unser flexibler Ansatz ermöglicht es uns, uns an Ihre Projektziele und -anforderungen anzupassen, damit Sie sich keine Sorgen machen müssen.

Als zuverlässiges Dienstleistungsunternehmen für künstliche Intelligenz integrieren wir KI in verschiedene Prozesse, um die langfristige Effizienz zu steigern und die Geschäftskontinuität zu gewährleisten. Durch eine sorgfältige Analyse identifizieren wir Bereiche und Abläufe, in denen KI-gestützte Lösungen einen erheblichen Mehrwert für Ihr Unternehmen schaffen können, damit Sie das volle Potenzial von KI nutzen können.

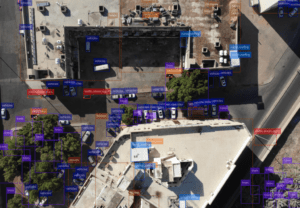

Computer Vision und Bildverarbeitung

Nutzen Sie die Leistungsfähigkeit von Computer Vision, um eine aussagekräftige Bildanalyse und -verarbeitung voranzutreiben und so Ihr Wachstum zu steigern und geschäftliche Herausforderungen zu lösen. Unsere Computer-Vision-Technologie, die Videoanalyse, Objekterkennung und Bildanalyse umfasst, kann Ihnen helfen, aussagekräftige Informationen aus Videos und Bildern zu extrahieren und in verwertbare Erkenntnisse umzuwandeln. Ganz gleich, ob Sie nach Bildsegmentierung, emotionaler Analyse, optischer Zeichenerkennung, Gesichtserkennung oder kontextbezogener Bildklassifizierung suchen, AI Superior hat das Richtige für Sie.

Verarbeitung natürlicher Sprache (NLP)

Jede Kundeninteraktion, sei es über soziale Medien, E-Mail oder Chats des Kundensupports, erzeugt jede Sekunde eine große Menge unstrukturierter Textdaten, die für Unternehmen wertvoll sein können. Mit unseren Services für die Verarbeitung natürlicher Sprache können Sie aus diesen Daten unschätzbare Erkenntnisse gewinnen, verschiedene Textanalyseprobleme wie Stimmungsanalysen lösen und in Sekundenschnelle aussagekräftige Informationen finden. Unsere Experten helfen Ihnen auch bei der Entwicklung robuster NLP-Anwendungen mit Funktionen wie Fragebeantwortung, Spracherkennung, semantische Suche, maschinelle Übersetzung, Kontrolle von Spamming und emotionale Bedeutung.

Prädiktive Analytik

Aufgrund der sich ständig verändernden Unternehmenslandschaft reichen historische Daten nicht mehr aus, um eine rentable Kapitalrendite zu erzielen. Hier kann die prädiktive Analytik helfen. Sie nutzt sowohl aktuelle als auch historische Daten, um Trends und Einblicke in die Zukunft für eine bessere datengesteuerte Entscheidungsfindung zu liefern. Die prädiktiven Analysedienste von AI Superior helfen Ihnen, Maßnahmen auf der Grundlage von Kundenverhalten und prognostizierten Markttrends zu ergreifen. Von der Betrugserkennung über die Vorhersage von Geräteausfällen bis hin zur Vorhersage von Markttrends - wir garantieren zuverlässige und genaue Vorhersagemodelle, die Ihr Geschäft ankurbeln können.

BI-Lösungen

Treffen Sie mit unseren BI-Lösungen intelligentere Entscheidungen auf der Grundlage von Geschäftsdaten. Wir helfen Ihnen, Verbesserungsmöglichkeiten, organisatorische Probleme und neue Chancen für Ihr Unternehmen zu erkennen, indem wir unstrukturierte Rohdaten aus verschiedenen Quellen nutzen. Mit unseren BI-Lösungen können Sie die betriebliche Effizienz verbessern und datengestützte Entscheidungen und Strategien überzeugend visualisieren.

Big Data-Analytik

Treffen Sie schnellere und bessere Entscheidungen mit Big-Data-Analysen in Echtzeit. Mit unserem Fachwissen im Bereich Big Data Analytics können wir Sie bei der Implementierung von Analysefunktionen unterstützen, mit denen Sie geschäftliche Herausforderungen lösen, künftige Ergebnisse vorhersagen und neue verwertbare Erkenntnisse und Muster gewinnen können, die Ihr Unternehmen effizienter machen. Sie können auch Daten aus verschiedenen Quellen analysieren, z. B. Protokolle, Transaktionsanwendungen und Sensoren, um Möglichkeiten für die Entwicklung neuer Dienstleistungen und Produkte zu ermitteln und potenzielle Risiken und Kundenbedürfnisse abzuschätzen.

Wir entwickeln preisgekrönte KI-Lösungen für verschiedene Geschäftsbereiche.

Bei AI Superior verfolgen wir einen systematischen Ansatz für alle KI-Entwicklungsprojekte. Wenn Sie uns als Partner wählen, können Sie Folgendes erwarten:

Entdeckungsphase:

Wir beginnen mit einem gründlichen Verständnis des Problems, das Sie lösen wollen. In enger Zusammenarbeit sammeln wir Erkenntnisse und legen die allgemeine Richtung und den Ansatz für die Lösung fest. Wir geben Ihnen eine grobe Einschätzung des Projektumfangs und der erwarteten Ergebnisse.

Ersteinrichtung:

Sobald wir Ihre Anforderungen verstanden haben, befassen wir uns eingehender mit Ihrem Team und den für ein erfolgreiches Projekt erforderlichen Daten. Wir bewerten den verfügbaren Datensatz, um festzustellen, ob KI die optimale Lösung für das anstehende Problem ist.

MVP bauen:

Wir verfolgen einen schrittweisen Ansatz, indem wir klein anfangen und den verfügbaren Datensatz nutzen, um die Tragfähigkeit unserer Idee zu testen. Auf diese Weise können wir die Wirksamkeit der vorgeschlagenen Lösung ermitteln und beurteilen, ob sie weitere Investitionen wert ist.

Skalieren und Integrieren:

Nach der erfolgreichen Entwicklung und Prüfung eines Prototyps konzentrieren wir uns auf die Integration der KI-Lösung in Ihr bestehendes System. Wir sorgen für eine nahtlose Kompatibilität mit Ihren Daten, nehmen die Feinabstimmung der Modelle vor und nehmen bei Bedarf notwendige Anpassungen vor.

Auswertung der Ergebnisse:

Wir arbeiten eng mit Ihnen zusammen, um die Ergebnisse der implementierten KI-Integration umfassend zu bewerten. Unser Ziel ist es, wertvolle Erkenntnisse zu liefern und deren genaue Interpretation sicherzustellen, damit Sie den maximalen Nutzen aus der KI-Lösung ziehen können.

für Startups

AI Superior bietet feste KI-Entwicklungspläne, die auf die Unterstützung von Startups in jeder Phase des Softwareentwicklungsprozesses zugeschnitten sind. Vom KI-Konzeptnachweis (PoC) bis hin zu vollständig skalierbaren Produkten, die fortschrittliche KI-Modelle nutzen, gewährleisten unsere Pläne ein garantiertes Ergebnis zu einem vordefinierten Preis.

Kundenspezifische KI-Lösungen: Wir entwickeln KI-Lösungen, die auf Ihre geschäftlichen Anforderungen und Herausforderungen zugeschnitten sind. Unsere KI-Experten arbeiten eng mit Ihnen zusammen, um Ihre individuellen Anforderungen zu verstehen und KI-Systeme zu entwickeln, die Ihre Bedürfnisse erfüllen, Ihre Effizienz verbessern, Ihnen einen Vorsprung vor der Konkurrenz verschaffen und Innovationen vorantreiben.

KI-Beratung: Wir haben uns auf die strategische Beratung von Unternehmen spezialisiert, die KI einsetzen möchten, um ihr Wachstum zu fördern und ihre Abläufe zu verbessern. Die Experten von AI Superior bewerten Ihre Geschäftsanforderungen, identifizieren KI-Möglichkeiten und entwickeln eine Strategie für die Entwicklung und Implementierung von KI.

Implementierung: Sobald ein Plan vorliegt und eine KI-Lösung als praktikabel erachtet wird, arbeitet das KI-Beratungsunternehmen an der Umsetzung des Projekts. Dazu gehören der Aufbau des erforderlichen Rahmens, die Auswahl und Anpassung des Modells und die Integration der KI-Lösung in das bestehende System.

KI-Schulung & Ausbildung: Wir bieten Schulungsmodule, Workshops und Vorträge für Unternehmen an, die ihre Mitarbeiter im Bereich KI weiterbilden möchten. Von Kodierungsregeln bis hin zu Data-Science-Teamtrainings und von Workshops zu maschinellem Lernen und Data Mining bis hin zu Vorlesungen über KI-Softwareentwicklung - wir sind bestrebt, führende KI-Fähigkeiten zu vermitteln, die Ihr Unternehmen in der heutigen, sich ständig verändernden Geschäftslandschaft relevant halten können.

KI-Integration und -Einführung: Wir von AI Superior helfen Unternehmen bei der Integration von KI in ihre bestehenden Systeme und Arbeitsabläufe. Unsere Experten können KI in bestehende Softwareanwendungen einbinden, Modelle und Algorithmen für eine schnellere Leistung optimieren und sie nahtlos in Ihre bestehenden Prozesse einbauen.

Datenanalyse: Die Experten von AI Superior helfen Unternehmen, mithilfe von KI wertvolle Informationen aus Rohdaten zu extrahieren. Wir können Ihnen helfen, Trends und Muster zu erkennen und verwertbare Erkenntnisse für datengesteuerte Entscheidungen zu gewinnen.

Der Einsatz von KI zur Analyse des Kundenverhaltens und der Kundenpräferenzen sowie zur Bereitstellung von personalisierten Erlebnissen und maßgeschneiderten Empfehlungen kann zu einer höheren Kundenzufriedenheit, höheren Konversionsraten und einer stärkeren Bindung und Loyalität führen, was letztlich gut für das Geschäft ist.

KI kann auch alltägliche und sich wiederholende Aufgaben automatisieren, so dass sich Ihre Mitarbeiter mehr auf Innovationen als auf Routineaufgaben konzentrieren können. Sie kann auch große Datenmengen schnell und effizient verarbeiten und komplexe Berechnungen durchführen, was zu höherer Produktivität, weniger menschlichen Fehlern und besserer Effizienz führt. Außerdem hilft die Automatisierung sich wiederholender Aufgaben Unternehmen, Ressourcen und Zeit zu sparen.

Die vollständige Nutzung von KI kann Ihnen auch einen Vorsprung vor Ihren Mitbewerbern verschaffen, da sie es Unternehmen ermöglicht, neue Chancen zu erkennen, schnell auf Marktveränderungen zu reagieren und schneller zu innovieren.

Zahlreiche Plattformen bieten KI als Service an und ermöglichen es Ihnen, mit ihren ML-Algorithmen und -Services zu experimentieren. Wir von AI Superior wissen, dass die Auswahl der richtigen Tools und Plattformen, die Ihre Anforderungen auf dem ständig wachsenden Markt vollständig erfüllen, überwältigend sein kann, aber unsere KI-Berater können Ihnen helfen. Unsere Experten können Sie durch den Auswahlprozess führen und Ihnen helfen, alle notwendigen Tools in Ihr Projekt zu integrieren.

Chatbots für einen besseren Kundenservice: Unternehmen können ihre Kundendienstprozesse mit Chatbots rationalisieren und verbessern und ihre Kundendienstmitarbeiter für Probleme freistellen, die menschliches Eingreifen erfordern. Chatbots können Kunden auch an Vertreter weiterleiten, die besser auf ihre Fragen eingehen können und rund um die Uhr für die Lösung von Kundenanfragen zur Verfügung stehen.

Personalisierte Empfehlungen: KI kann das Kundenverhalten analysieren und Produkte empfehlen, die den Interessen des Nutzers entsprechen. Dies ist besonders bei E-Commerce- und Streaming-Websites beliebt. Durch die Analyse der Sendungen und Filme, die Sie sich am häufigsten ansehen, oder der Produkte, nach denen Sie am häufigsten suchen, kann die KI Ihnen ähnliche Titel präsentieren, um Sie länger auf der Plattform zu halten.

Zielgruppensegmentierung für gezielte Kampagnen: KI wird in der Werbebranche eingesetzt, um Nutzer zu segmentieren und gezielte Kampagnen zur Steigerung des Absatzes durchzuführen, insbesondere in wettbewerbsintensiven Branchen.

Stimmungsanalyse für Kundenzufriedenheit: Die Stimmungsanalyse mit KI ermöglicht es Unternehmen, Kundenreaktionen zu messen und Erkenntnisse darüber zu gewinnen, wie die Kunden ihre Marke sehen, indem sie Bewertungen, Rezensionen und Beiträge, in denen die Marke erwähnt wird, durchgehen. Diese Erkenntnisse helfen Unternehmen, Bereiche zu identifizieren, die verbessert werden können, um einen besseren Kundenservice zu gewährleisten.

Betrugserkennung: Unternehmen nutzen KI, um Betrug zu erkennen und darauf zu reagieren und Cyberkriminalität zu verhindern. Verschiedene Algorithmen des maschinellen Lernens werden eingesetzt, um verdächtige Transaktionen zu erkennen. Wenn ein Betrugsrisiko besteht, wird die Transaktion gestoppt und die betroffenen Parteien werden über das Risiko informiert.

Optimierung der Lieferkette: KI ist auch für Unternehmen hilfreich, die Schwierigkeiten haben, Produkte rechtzeitig zu liefern. Sie kann dabei helfen, die Material- und Versandpreise vorherzusagen und die Zeit abzuschätzen, die die Produkte für den Durchlauf durch die Lieferkette benötigen. Auf diese Weise können Unternehmen bessere Entscheidungen über die optimale Art des Produktversands treffen. Es wird auch häufig verwendet, um schnellere Routen zu finden und den Lieferfahrern zu helfen.

Lassen Sie uns alle Vor- und Nachteile betrachten, die es mit sich bringt, ein Pionier in der Branche des maschinellen Lernens zu sein und SOTA-Ansätze in Ihr Unternehmen zu integrieren. Bei AI Superior sind wir der festen Überzeugung, dass es wichtig ist, die neuesten akademischen Erkenntnisse im Bereich ML zu verfolgen, neu vorgeschlagene Methoden des maschinellen Lernens, Trainingsdatensätze und alles, was wichtig ist, zu kennen […]

Herkömmliche Methoden zur Überwachung moderner Städte erweisen sich oft als ineffizient. Aufgrund des hohen manuellen Aufwands erfordern sie viele Ressourcen, die einer Stadt möglicherweise fehlen. Zudem ist manuelle Arbeit fehleranfällig. Fortschritte in der KI und den damit verbundenen Hardwarelösungen können die […]

Natural Language Processing, allgemein bekannt als NLP, ermöglicht es Computerprogrammen, die menschliche Sprache sowohl geschrieben als auch gesprochen zu verstehen. Es handelt sich um die sogenannte natürliche Sprache, ein Teilgebiet der künstlichen Intelligenz. Seit über 50 Jahren bietet NLP vielfältige Anwendungsmöglichkeiten in verschiedenen Bereichen, darunter […]

Unabhängig davon, ob Sie bereits mit einem KI-gestützten System gearbeitet haben oder nicht, verblüfft der aktuelle Fortschritt auf diesem Gebiet selbst Menschen mit wenig Vorkenntnissen. Die Möglichkeiten, die KI in jedem Bereich und jeder Nische bietet, sind wirklich großartig und wachsen mit jedem Jahr weiter. Wenn Sie […]

Für Führungskräfte und Entscheidungsträger kann es eine große Herausforderung sein, den richtigen Zeitpunkt und die passende Vorgehensweise für die Einführung neuer Technologien zu bestimmen. Künstliche Intelligenz (KI) ist eine solche Technologie und nimmt im Markt für neue Technologien eine Sonderstellung ein. Schätzungen zufolge werden bis 2021 801,3 Billionen aller neuen Technologien auf KI basieren. Vereinfacht gesagt: […]

- +49 6151 3943489

- [email protected]

- Robert-Bosch-Str.7, 64293 Darmstadt, Deutschland